在讨论SEO优化时,很多人容易忽略的一个方面就是蜘蛛日志文件。通常,日志文件只在网站出现问题时才受到关注,但实际上,通过仔细分析蜘蛛日志,我们可以获得丰富的信息,甚至发现站点存在的一些问题,这对于SEO来说至关重要。

▍了解蜘蛛日志:

蜘蛛日志是指在搜索引擎向服务器发送请求时生成的访问记录文件。以nginx作为反向代理为例,每当有请求到达网站服务器,nginx就会生成相应的蜘蛛日志文件。这些日志文件通常存储在名为access.log的文件中,记录了搜索引擎蜘蛛的浏览记录。

▍查找蜘蛛日志:

对于nginx服务器,访问日志文件默认保存在名为/var/log/nginx/的目录下。通过使用命令find / -name access.log可以找到访问日志文件的确切位置。在这个目录中,可以找到有关站点访问的详细记录。

需要注意的是,如果access.log文件较大,如几十兆,建议不要直接在服务器上查看,而是将其下载到本地机器进行分析。因为分析日志需要一些资源占用较大的命令,直接在生产环境中进行可能会影响正常业务。

在SEO优化中,蜘蛛日志是一个常常被忽略但极具潜力的资源。通过详细分析蜘蛛日志文件,我们可以获取各种信息,甚至发现站点存在的问题,对于SEO优化至关重要。

▍蜘蛛日志的基本构成:

以下是一个典型的蜘蛛日志的基本构成部分,以nginx默认格式为例:

221.221.153.47 - - [25/Jun/2018:11:39:13 +0800] "GET / HTTP/1.1" 200 19285 "https://www.baidu.com/from=844b/bd_page_type=1/ssid=0/uid=0/pu=usm%401%2Csz%401320_2001%2Cta%40iphone_1_11.3_3_604/baiduid=6EC3CDA4AF6..." "Mozilla/5.0 (iPhone; CPU iPhone OS 11_3 like Mac OS X) AppleWebKit/604.1.34 (KHTML, like Gecko) CriOS/67.0.3396.87 Mobile/15E216 Safari/604.1"

解读:

221.221.153.47 - 客户端的IP地址

[25/Jun/2018:11:39:13 +0800] - 访问时间

GET - 请求方式

/news/7fcfca6a-0e14-42a0-a9f8-c0ffca0d8ab5 - 请求地址

HTTP/1.1 - 请求协议

200 - HTTP状态码

19285 - 请求的页面大小

https://www.baidu.com/from=844b/bd_... - 来源地址

Mozilla/5.0 (iPhone; CPU iPhone OS 11_3 like Mac OS X)... - 客户端浏览器的相关信息(Agent)

搜索引擎Agent信息示例:

以下是一些常见搜索引擎Agent信息,供参考:

Google蜘蛛:Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

Baidu蜘蛛:Baiduspider+(+http://www.baidu.com/search/spider.html)

Yahoo!蜘蛛:Mozilla/5.0 (compatible; Yahoo! Slurp/3.0; http://help.yahoo.com/help/us/ysearch/slurp)

微软Bing蜘蛛:msnbot/2.0b (+http://search.msn.com/msnbot.htm)

等等...

通过分析客户端Agent信息,我们可以针对性地过滤和筛选特定搜索引擎的访问记录,比如通过关键词"Baiduspider"来筛选百度蜘蛛的访问记录。这种方法有助于更好地理解搜索引擎对网站的爬取情况。

在利用蜘蛛日志进行SEO优化时,我们需要掌握一些常用的分析命令,以下是其中一些常见的例子:

获取百度蜘蛛的详细爬取记录:

统计百度蜘蛛的爬取次数:

统计百度蜘蛛爬取某个页面的记录(url为页面的相对地址):

这些命令中的grep工具是一种强大的文字搜索工具,通过它,我们可以灵活地筛选和查找我们关心的日志内容,提高工作效率。

▍如何利用蜘蛛日志:

通过分析蜘蛛日志,我们可以获得以下关键信息:

判断网站程序是否符合搜索引擎的抓取规范:

通过蜘蛛日志,我们能够了解蜘蛛是否对站点进行了抓取,以及抓取是否成功。通过判断抓取失败的原因,我们可以及时调整网站程序,符合搜索引擎的规范,提高收录效率。

统计蜘蛛的抓取频次:

恶意蜘蛛可能会频繁对网站进行抓取,导致服务器运行异常。通过蜘蛛日志的分析,我们可以发现恶意蜘蛛的足迹,进而限制其访问频率或者禁止其访问,保障服务器的稳定。利用robots.txt文件规定蜘蛛的访问规则也是一种有效的手段。

分析蜘蛛的访问路径,优化站点结构:

通过日志文件,我们能够深入分析蜘蛛的访问路径,了解其对网站的爬取行为。这有助于优化站点的结构,提升用户体验,进而提高搜索引擎的排名。

通过这些分析,我们可以更全面地了解蜘蛛的爬取行为,有针对性地进行优化,提升网站在搜索引擎中的表现。

▍挖掘日志更多信息

在深入挖掘日志的过程中,我们可以获取更多有价值的信息:

排查网站错误:

通过分析日志中的状态码,可以及时排查网站是否存在问题,例如死链、程序错误、页面失效等。这有助于提升网站的可靠性和用户体验。

分析用户行为习惯:

利用日志文件,我们能够了解用户对整站页面的访问次数、访问时间和访问路径。通过这些数据,我们可以得出用户的行为习惯和关注点,有针对性地进行内容优化,提高用户满意度。

获取用户画像:

通过深入分析日志,我们可以获得用户的地理区域、来源地址、浏览设备以及搜索引擎等信息。这些数据有助于构建用户画像,为个性化推荐和精准营销提供基础。

防范恶意攻击:

通过对日志中高频访问的用户进行鉴定,我们能够及早发现潜在的恶意攻击。通过阻止非正常的高频度访问,可以有效避免不必要的资源浪费和服务器压力。

结语:

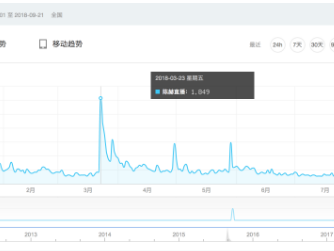

本文介绍了日志分析的基本方法和操作,然而,更多的细节和技巧需要结合站长工具进行深入研究。在实际场景中,挖掘更多的信息和解决方案需要读者不断摸索和实践。SEO是一个长期的过程,成功在于谁能够在实践中做到更为极致的优化。