什么是SEO

搜索引擎优化(Search Engine Optimization,简称SEO)是一种通过优化网站以提高在搜索引擎自然搜索结果中排名的技术。其目的是增加免费流量,展现更好的形象。

简单来说,SEO涉及通过自然搜索结果获取流量的技术和过程。

▍搜索引擎工作原理

为了了解SEO,首先需要了解搜索引擎的工作原理。其流程可以简化为以下几步:

爬虫抓取网页内容: 爬虫从一个页面出发,提取其他页面的链接,形成一个请求对象链。有良好的SEO需要在各大网站上拥有外链,提高被搜索引擎爬虫抓取的几率。

分析网页内容: 爬虫获取HTML后,对其内容进行去杂、分词、建立索引数据库等操作。索引数据库记录词在文档中的出现、次数、位置等信息,以便搜索时快速查找。

搜索和排序: 根据输入的关键词查询索引数据库,对结果进行处理和排序,生成搜索结果页面。

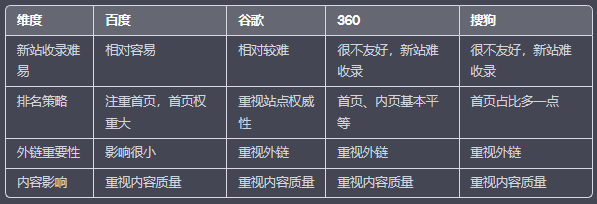

不同搜索引擎的SEO差异

▍网站优化方向

网站优化主要分为两个方向:结构调整和页面代码优化。

网站结构调整:

结构要清晰,一般分为首页、频道页、文章页。

结构要扁平,层数不要超过三层,以便爬虫能够顺利抓取。

导航要简明,确保每个页面都包含清晰的导航,使用面包屑导航对于内容丰富的网站很有帮助。

页面代码优化:

优化内链,改善用户体验,增加页面浏览量,帮助搜索引擎更好地理解网站结构和内容。

外链要谨慎使用,以避免被搜索引擎视为垃圾链接。

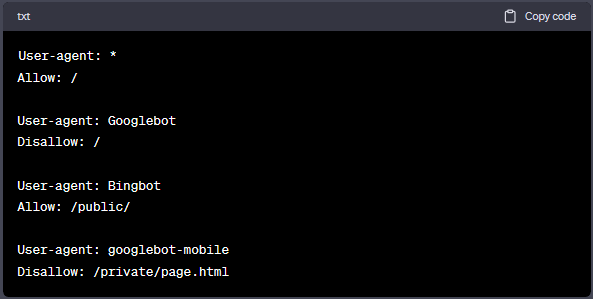

▍Robots.txt 文件的重要性

Robots.txt 文件用于告诉搜索引擎爬虫哪些页面可以被爬取,哪些页面应该被忽略。合理配置可提高搜索引擎对网站的索引效果。

建议即使允许抓取所有内容,也要创建一个空的robots文件,放在根目录下,以确保搜索引擎正确解读。

▍内链

内链是将一个网站内部的页面链接到同一网站内的其他页面的行为。内链的优势在于改善用户体验、增加页面浏览量,并协助搜索引擎爬虫更好地理解网站结构和内容,从而提高网站的收录和权重。

▍外链

外链指的是两个不同网站之间相互链接的过程。除了提高网站的权重外,外链还有助于提升特定关键词的排名。然而,使用外链需要谨慎,以免被搜索引擎视为垃圾链接,可能对排名产生负面影响。

▍代码优化

HTML语义化

使用 <h1> 标签全局只能存在一个,不应滥用,合理使用 <h2>, <h3>, <h4> 等标签。

跳转应使用 <a> 标签,并确保有 href 属性,避免使用 JavaScript 进行跳转。

文章应使用 <article> 标签承载。

所有 <img> 标签都需要添加 alt 属性值以说明图片内容。

正确的TDK标签

TDK标签包括:

标题标签 <title>(T):格式应以关键词 - 副关键词 | 品牌名为标准,长度最好在50 ~ 60个字符之间。

网站的描述标签 <description>(D):长度最好在155 ~ 160个字符之间,使用吸引用户的话术,每个网页创建不同的描述。

关键词标签 <keywords>(K):最好在5 ~ 10个之间,用逗号或者下划线隔开,搜索量大的在前,搜索量小的在后,不可重复出现。

避免爬虫陷阱

Flash制作的网站无法被搜索引擎索引。

过多的页面重定向或跳转会被爬虫认定为垃圾网站,降低排名。

搜索引擎爬虫不会执行 JavaScript代码,需避免使用JS链接。

要求用户登录方可访问的网站,可能导致搜索引擎爬虫无法访问。

URL设计

规范、简单、易理解的URL能够更好地被搜索引擎抓取。

URL应该清晰明了,避免使用数字、特殊字符或随机字符,以便爬虫能够快速理解页面主题。

在URL中包含相关的关键字可以提高页面在搜索引擎中的排名。

URL长度越短越好,使用连字符(-)分隔单词有助于提高可读性。

避免过多的参数字符串,使用静态URL而不是动态URL,采用301进行重定向以避免重复内容。

使用HTTPS协议提高网站安全性,搜索引擎通常更青睐收录安全性高的网站。

性能优化

页面速度是重要的排名因素,也影响到爬虫的爬取效率。

优化页面耗时

良好的首屏加载速度有助于提高排名,并为用户提供更好的体验和服务。

优化页面体积 (< 125 kb )

搜索引擎对于页面源码尺寸有限制,超过限制可能导致截断处理。

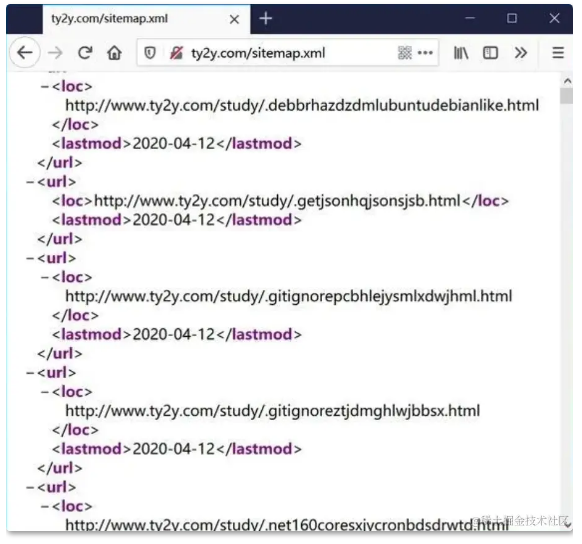

网站地图(Sitemap)

Sitemap是一个XML文件,包含了网站上所有重要页面的URL和元数据。它通知搜索引擎哪些页面可供抓取,提高网站的智能抓取效果。

结语

SEO是一个充满挑战和复杂性的领域,虽有一定规则,但也包含一些玄学。积累经验和进行AB实验是探索SEO奥秘的方法。然而,无论如何,网站内容的丰富和有价值仍然是做好SEO的最基本前提。