前言

不久前,我和朋友聊天时得知他朋友公司新建的网站在百度等国内搜索引擎中无法被搜索到。他向我咨询如何让一个网站被搜索引擎收录。我以前偶尔看到有关搜索引擎排名优化的文章,虽然时常点进去看一看,但因为没有实际应用场景,后来甚至变得懒得点开。不过,这次我深切感受到了SEO的实际价值,因此决定花一些时间搜集相关资料,系统地学习一下。或许未来的某一天,这些知识会派上用场。

什么是SEO?

SEO代表Search Engine Optimization(搜索引擎优化),简而言之,是对网站进行的一种自然排名优化。自然排名与竞价排名相对应,两者之间的区别显而易见:

竞价排名需要付费,当搜索相同关键字时,网站会出现在前列,并标有广告字样标签(此处仅指百度)。

自然排名是免费的,当搜索相同关键字时,网站一般排名较靠后,并且不会显示广告字样。

SEO的目的是通过利用搜索引擎的排名规则,提高网站在相关领域的自然搜索排名,从而获得一定的精准流量。对于企业而言,SEO在曝光、引流和客户获取方面具有重要意义。搜索引擎的第一页只有10个展示位,而参与排名的网站数量庞大。因此,大多数网页注定无法进入第一页。因此,对于SEO优化的效果,我们不应抱有过高的期望。经过SEO优化的网站,经过一段时间后,如果能进入搜索引擎前五页,就算是不错的表现。

SEO实施方法:

关键词挖掘和布局

提升网站质量

收录优化

网页代码优化

定义爬虫协议和网站地图

永久重定向

内链优化

URL优化

其他

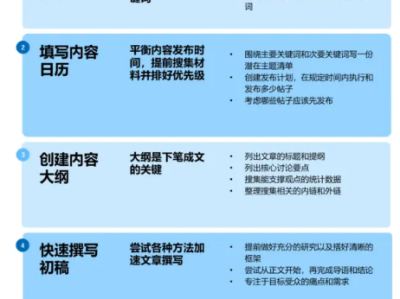

▍关键词挖掘与布局

关键词挖掘

热门关键词

挖掘关键词的方法有很多,其中一种可行的方式是通过搜索下拉框选择关键词。这方法看起来比较可靠,对于如何实施,你可以参考相关文献。还有其他方法可以由读者自行尝试。

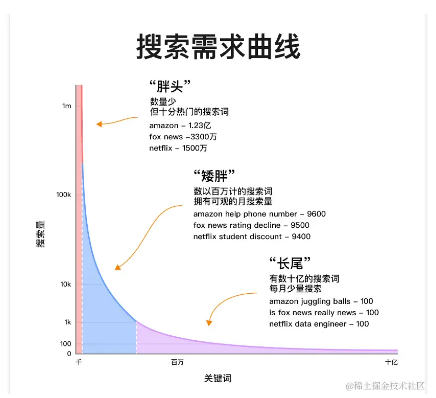

长尾关键词

长尾关键词指的是那些虽然搜索量不大,但与目标关键词相关,且能够为网站带来组合型搜索流量的关键词。这类关键词数量众多,形象地称之为长尾关键字。你可以参考相关文献中罗列的实用方法来挖掘这些关键词。

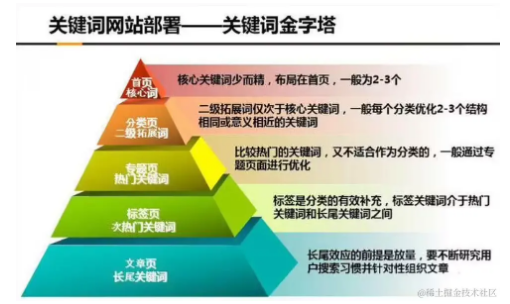

关键词布局

在关键词布局上,建议参考关键词金字塔布局。在设置关键词密度时,要均匀地分配关键词位置,避免关键词堆积,以利于SEO优化。

在页面中放置关键词的位置和数量应该遵循一定原则。在标题中出现关键词并放在前面是一个不错的选择,因为页面标题的权重相对较高,网页爬虫会更优先爬行这部分内容。另外,需要注意的是,真正为网站带来大量流量的通常是长尾关键词。在长尾关键词的优化过程中,可以利用站长工具查看关键词的排名,找出排名在前5-6页之前的关键字,将其中流量较高的3~4个关键词放在首页,其余的则均匀地分布在对应的分类栏目页中。

▍提升网站质量

加载速度

通常来说,网站加载速度在3秒以内被认为是正常体验,而在2秒以内则是更佳的体验。如果您的网站加载速度超过4秒,考虑进行优化是必要的。网站性能直接影响到SEO排名,这是由于以下直接原因:

如果网站加载缓慢,搜索引擎可能认为该网站用户体验不佳,从而导致排名下降。

优化SEO的目标之一是提高转化率,而网站卡顿会导致用户流失。

网站加载速度也会影响搜索引擎的爬取频次。

提高网站加载速度的思路包括:

减少资源请求,例如开启缓存、按需加载页面资源、分页加载数据、使用雪碧图、图片懒加载。

减小请求资源文件体积,例如压缩图片、JS、CSS等页面资源文件。

提高并发量和响应速度,例如采用分布式负载均衡、开启HTTP/2.0协议、使用CDN。

网站优化的方法众多,可以查找相关文章深入了解。

内容与交互

这方面只能提供一些建议,具体的实施方法需要由网站开发者思考和执行。

提供有价值的信息,突出主题,保持清晰的条理。

精心创作正文内容,确保不平庸,数据来源具有权威性。

使用图片和视频来分解内容,使其更易于浏览。

确保网站布局合理,背景与文字对比鲜明,色调统一,让用户感到舒适。

设置明确的主题,营造出适当的情感或氛围。

▍收录优化

为了加快搜索引擎对网站的爬取和提升收录速度,可以采取主动向各搜索引擎管理平台提交网站的策略。以下是一些常用的搜索引擎管理平台:

百度搜索资源平台

搜狗搜索资源平台

头条搜索站长平台

360站长平台

谷歌搜索中心

必应-网站管理员工具

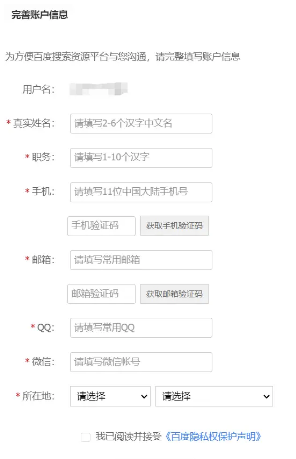

在使用这些平台之前,需要注册账号,并提供一些必要的个人信息。注册时需要指定一个真实存在的网站,因此如果没有实际的项目,可能会受到一些限制。在注册完成后,可以按照平台的指引提交网站信息,促进搜索引擎更快地对网站进行爬取和收录。

📔请注意,使用这些平台需要谨慎提供准确的信息以确保注册的可信度。

▍网页代码优化

页面标题(Title)

每个页面的标题都应有所不同,关键词的重复次数最好不超过2次,而且关键词应尽量靠前。

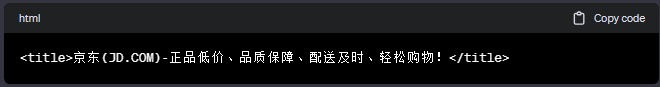

首页示例:

列表页面示例:

详情页面示例:

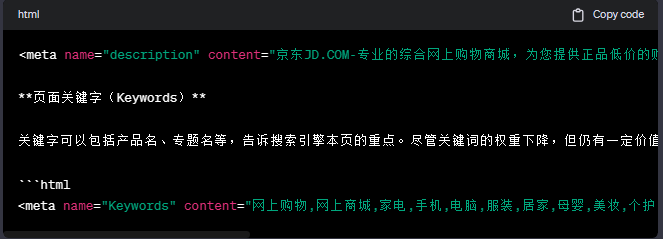

页面描述(Description)

描述内容不超过150个字符,与页面内容相关。

避免过度堆砌关键词,而是高度概括页面内容,不同页面的描述要有所不同。

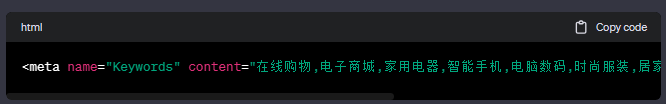

页面关键字(Keywords)的优化策略

在页面的关键字优化中,Keywords的设置仍然是一项重要的优化手段。尽管各大搜索引擎已经对Keywords的权重进行了降低,但仍然值得我们进行关注和优化。

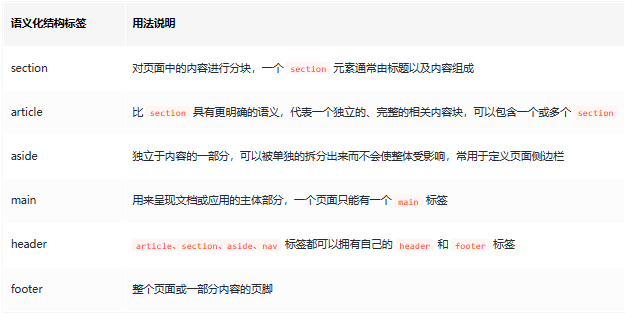

使用语义化标签

使用语义化结构标签

其他注意事项

当文字过长时,使用CSS实现省略号,以确保搜索引擎能够抓取完整的文字。

减少对iframe的使用,因为搜索引擎不会抓取iframe的内容。

▍定义爬虫协议与网站地图

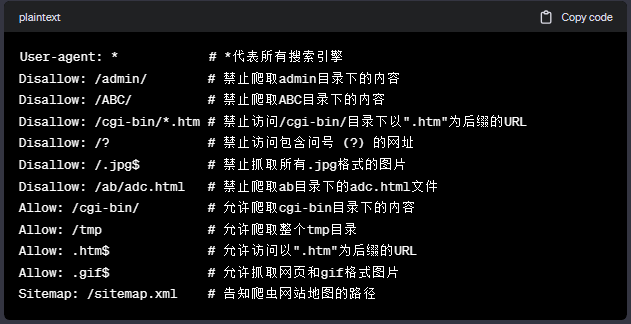

爬虫协议 (robots.txt)

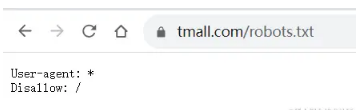

robots.txt,也称为robots协议,是一种国际互联网界通行的道德规范,放置在网站根目录下。其作用是告诉搜索引擎如何抓取网站页面,明确哪些页面可以被抓取,哪些不可以。这对于保护敏感数据、避免爬取未完善的页面对SEO的影响,以及引导蜘蛛爬取页面具有重要意义。

robots.txt支持以下配置规则:

理解这些规则后,可以利用robots协议生成工具来生成robots.txt文件。通常,这个文件可以通过在网站域名后加上'/robots.txt'路径来访问,例如网站域名/robots.txt。

举例来说,掘金的robots.txt内容主要设置了禁止爬取的后端目录。

而天猫则禁止一切搜索引擎抓取其内容,确保更严格的隐私保护。

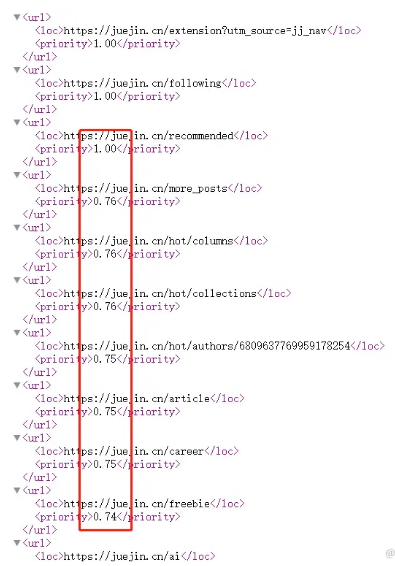

▍网站地图(Sitemap)

网站地图是一种用于将网站的所有或大多数网址集中在一个标准地图文件中的工具。网站地图文件可以采用多种格式,包括XML文件(例如sitemap.xml)、HTML文件(例如sitemap.html)、TXT文件(例如sitemap.txt)或RSS文件(例如rss.xml)。目前,XML格式的sitemap.xml是最流行的选择,被主要搜索引擎如百度、Google、Bing等广泛采用。维护并更新网站地图有助于搜索引擎及时抓取新页面,提高网站内容的可见性。

有许多工具可用于自动生成网站地图,例如使用此工具,可以快速生成网站地图。用户只需输入网站的URL,工具会生成对应的sitemap.xml文件,其中包含各页面的信息,如权重。

以掘金网站为例,生成的sitemap.xml文件内容如下。

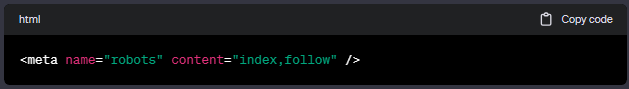

▍Meta标签中的Robots项

通常情况下,robots标签的值为:

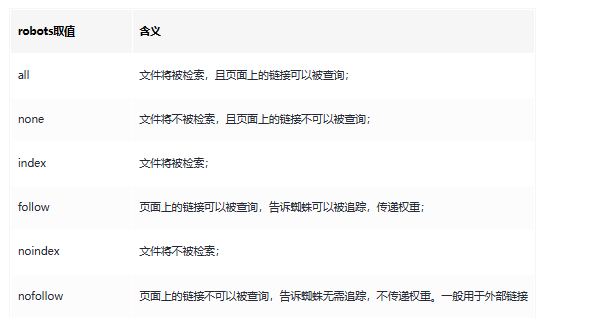

robots标签的取值及含义如下:

为了理解meta-robots的含义,需要熟悉几个概念。

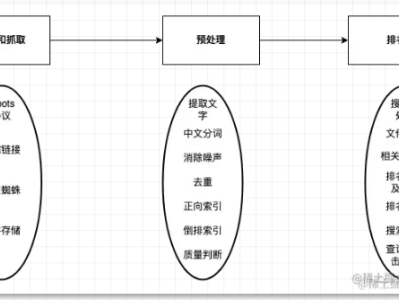

抓取和索引:搜索引擎行为解析

在搜索引擎的运作中,抓取和索引是两个独立但关键的环节。

抓取: 搜索引擎爬虫负责抓取特定网页的内容,类似于浏览器打开网页并查看实际内容的过程。

索引: 爬虫完成内容抓取后,搜索引擎会将认为有保存价值的网页内容存储在数据库中。可以将这个过程类比为爬虫将网页内容添加到自己的收藏夹。

在网站的meta-robots标签中,"文件将被检索"意味着告知爬虫该网页内容可被搜索引擎收录到其数据库。而"页面上的链接不可以被查询"则表示,如果网页中存在链接,不要在搜索结果中显示这些链接。

网站权重:搜索引擎排名的关键指标

网站权重是指一个网站在搜索引擎结果中的影响程度,高权重意味着更有可能在搜索结果中获得靠前排名。权重的评估通常通过国内两大站长工具进行虚拟评估,基于站点从搜索结果获取的预估流量,赋予相应的评级。该指标通常分为1-10级,级别越高,权重越大。

在权重的传递方面,涉及是否将当前页面的权重传递给引入的外部链接页面。一般情况下,只有将权重大的页面传递给权重小的页面才有意义。这种传递通常发生在友情链接中,将不知名网站放在知名网站的链接中,但通常需要付费。

你可以使用一些网站,比如爱站网或站长之家,来进行百度权重的查询。在查询中,你可能会发现像CSDN这样的网站在搜索引擎中的权重较高。

举例来说,当我搜索"less和sass的区别"时,发现在百度搜索结果的第一页主要显示了CSDN的内容,而掘金的内容并未显示。这突显了搜索引擎结果的差异。

需要注意的是,meta-robots项并不被所有搜索引擎支持,只有极少数的搜索引擎能够识别并按给定的值进行抓取。因此,建议使用robots.txt文件来更可靠地限制抓取。

▍使用301永久重定向的场景和配置示例

永久重定向(301 Redirect)在以下几种情况下是必要的:

网站替换域名: 当网站更换域名时,为避免流量损失,可通过301永久重定向旧域名到新域名。

页面被移除: 如果网站中某些页面被移除,为防止流量流失,可使用301重定向将这些页面指向合适的新页面。

页面路径发生变化: 网站改版或其他原因导致页面路径变化,为避免死链接,可通过301重定向来告知搜索引擎和用户新的页面路径。

多个域名指向同一站点: 当有多个域名需要指向相同的站点时,为确保一致性,可使用301永久重定向。

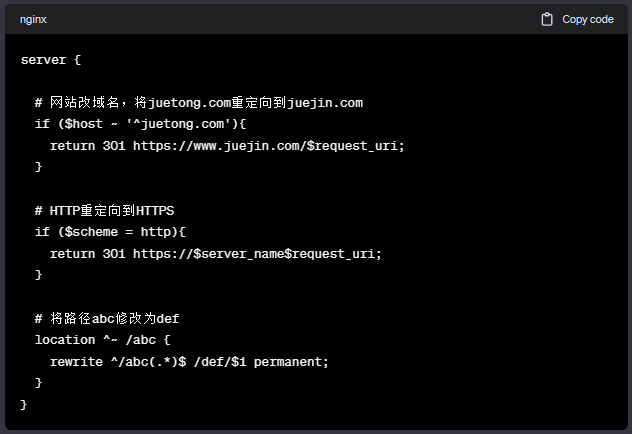

以下是在Nginx配置中实现上述场景的示例:

通过以上配置,实现了对旧域名的重定向、HTTP到HTTPS的重定向,以及路径修改的重定向。在实际应用中,根据具体需求可作适当调整。

▍优化内链结构提升网站效益

内链优化是SEO的关键之一,有效的内链策略可以提高页面蜘蛛抓取效率,增加网站收录数量,同时提升网站权重、关键词排名,以及提高用户体验。

构建内容关联内链

在文章中添加锚点或在文章底部增加内链,确保链接内容之间的关联性。例如,网站导航、面包屑、侧边栏、文章分类等都是内链的重要体现。在内容页面中加入查看详情链接,或在文章底部添加上一篇和下一篇文章的链接,建立页面之间的关联,避免孤立页面存在。

面包屑的重要性

添加面包屑导航可以告知用户当前所在位置,也方便用户返回到想要的地方。面包屑对于用户体验和搜索引擎的理解网站结构都具有重要作用。

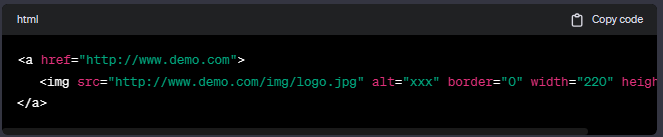

图片链接的利用

搜索引擎蜘蛛更容易识别文本链接,因此建议为产品图片添加文字链接,示例如下:

列表页的内链构建

列表页在产品列表和文章列表中非常常见,对于分页时,建议标记下方出现的1-2-3-4页,以方便蜘蛛抓取。

通过这些内链构建策略,可以提升网站的整体效益,增强搜索引擎对网站的理解,从而更好地为用户提供相关的信息。

▍精心设计URL以优化网站效果

URL是网站结构的重要组成部分,合理的URL设计可以提高用户体验和搜索引擎优化。以下是一些建议:

保持URL简短易读

短URL更易传播和复制,同时用户更容易记住。避免过长的URL,简洁的地址更有利于用户理解和记忆。

控制URL参数数量

尽量保持URL参数不超过3个,过多的参数会使URL显得复杂难懂,影响用户体验。

管理目录深度

限制URL目录的深度,建议不超过4层目录。过深的目录结构不仅难以理解,还可能对搜索引擎抓取产生负面影响。

提高可读性

确保URL具有良好的可读性,能够清晰地描述页面内容。避免乱写一气的字符,而是采用有意义的词汇。

包含关键词

在URL中包含关键词有助于SEO,搜索引擎更容易理解页面主题。但要注意自然融入关键词,不要过度堆砌。

小写字母和短横线

使用小写字母,防止因为大小写导致404错误。此外,使用短横线而不是下划线,因为搜索引擎将短横线作为空格处理,而下划线则会被忽略。

URL规范化

确保同一内容的不同URL都能规范到一个主要地址,防止搜索引擎将它们视为不同的页面。通过在头部添加规范的链接,告知爬虫网站的主要规范网址,避免权重分散。

通过以上URL设计和规范化的方式,可以有效提升网站的可读性、用户体验,同时为搜索引擎提供更清晰的页面信息。

▍其他:提升网站综合素质的关键措施

启用HTTPS协议

启用超文本传输安全协议(HTTPS)是搜索引擎排名的关键指标之一。相同域名下,采用HTTPS的站点比使用HTTP的站点更有利于排名。了解如何启用HTTPS协议的方法可以参考相关指南。

服务端渲染(SSR)的重要性

多数搜索引擎无法读取JavaScript动态生成的内容,这是为什么单页应用(SPA)框架需要实施服务器渲染(SSR)或预渲染的原因。通过在服务端获取动态数据、填充HTML页面,并返回给浏览器,网页爬虫就能够获取静态的网页内容。实现Vite + Vue3的SSR方法可参考相关文章,而React实现SSR的方法可查阅对应指南。

添加404页面

在网站设置404页面是至关重要的。当用户输入错误的页面地址时,若没有设置404页面,可能导致死链接的出现。这不仅不利于搜索引擎的收录,还会影响用户体验,甚至导致用户关闭网站。

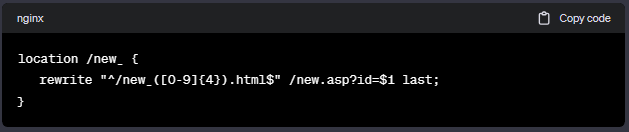

伪静态页面的配置

在SEO优化中,静态页面(如new_1234.html)相对于动态页面(如new.asp?id=1234)更容易被搜索引擎收录。通过在服务器配置中使用rewrite重写规则,将动态URL转换为静态URL,可以提高页面的搜索友好性。在nginx中的配置示例如下:

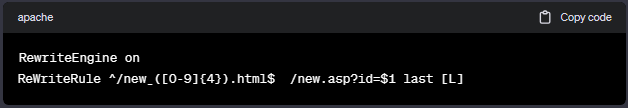

在Apache中,可以通过在项目下创建.htaccess文件,并写入如下内容来实现:

站外软文推广与友情链接交换

通过在其他平台(如今日头条、微信公众号、知乎、小红书等)发布软文,进行站外推广,可以有效提升网站曝光度。此外,与其他网站进行友情链接交换,相互推广,是一种有效的合作方式。许多公司的官方网站底部都设有友情链接,这是一种互惠共赢的策略。

最后,理论只有付诸实践才能真正发挥价值。本文提到的一些建议,若能在实际项目中得以贯彻,将更有助于提升网站的综合素质。